Kezdőoldal > Szoftver > RAID EE Technológia

RAID EE Technológia

Ahogy a merevlemez kapacitás növekszik, a RAID adat újraépítéshez szükséges idő is drasztikusan növekszik. Ez az egyik dolog, amely a legnagyobb problémát jelenti a vállalati tároló kezelők számára napjainkban. A múltban, amikor a merevlemez kapacitás csak 10GB – 100GB-ig terjedt, a RAID építés csupán körülbelül 10 percet vett igénybe, mely még nem probléma. Azonban, ahogy a lemezkapacitás több száz GB-ra, majd TB-ra nőtt, a RAID újraépítési idő órákra, majd napokra nőtt és vált elsődleges problémává a tároló kezelésben.

Miért időigényes a RAID Újraépítés

Ahogy a meghajtó kapacitás nő, a RAID újraépítési idő is folyamatosan növekszik, a hagyományos RAID architektúrákkal végzett újraépítési idő megnőtt több tíz órára, ha RAID lemezek mérete meghaladja a 4TB HDD kapacitást.

Különböző tényezők vannak hatással a RAID újraépítési időre:

- HDD kapacitás: A merevlemez kapacitás teszi ki a lemezcsoportot, minél nagyobb a merevlemez kapacitás, annál hosszabb az újraépítési idő.

- A lemezmeghajtók mennyisége: A lemezmeghajtók mennyisége, melyek a lemezcsoportba tartoznak, hatással vannak a szükséges időre, ami a rendszernek szükséges, hogy olvassa az adatot a fennmaradó kifogástalan merevlemezekről és írja azokat a hot spare merevlemezekre. A több lemez, hosszabb újraépítési idővel is jár.

- Újraépítési munka prioritás: A RAID újraépítés alatt, a rendszernek továbbra is az I/O hozzáférést kell igénybe vennie a front-end kiszolgáláshoz. Minél nagyobb a RAID újraépítési feladathoz rendelt prioritás, annál gyorsabb az újraépítés, de a front-end kiszolgáló annál kevésbé fokozza az I/O teljesítményt.

- Gyors újraépítés: A gyors újraépítési funkció engedélyezésével csak az aktuális kötet kapacitását szükséges újraépíteni, a fel nem használt lemezterületek nem épülnek újra.Ha a lemezcsoportban lévő területnek csak egy része van használatban, akkor az újraépítési idő rövidebb lesz.

- RAID szint: RAID 1 és RAID 10 közvetlen block-to-block replikációval gyorsabban fog újraépülni, mint a RAID 5 és RAID 6 paritás kalkulációval.

Tekintettel arra, hogy egyes merevlemez meghajtók meghibásodhatnak, minél több lemezmeghajtó van egy lemezcsoportban annál nagyobb a hibák lehetősége, ezért van egy felső korlát, hogy mennyi meghajtó lehet egy lemezcsoportban. Az előző tényezőkhöz képest a lemezmeghajtók kapacitásának növekedése az újjáépítési sebességet illetően elsődleges tényezővé vált. Az ilyen hosszú újraépítési idő természetesen nem minden felhasználó számára elfogadható. A hagyományos RAID problémáinak megoldása érdekében RAID EE technológiát alkalmazunk.

A RAID EE elmélete

A RAID EE több tárhelyet hoz létre egy lemezcsoportban, ezért RAID EE-nek nevezzük őket, hogy elkülönítsük az eredeti globális, helyi, valamint a dedikált részeket. A lemezterület minden sávja megőrződik és szétosztódik a lemezcsoportban.

Amikor a lemezek hibásak a lemezcsoportban, a hiányzó adat újraépítődik a megőrzött tartalék területekben. Mivel a beállításban lévő összes lemez az újraépített adatok célollomása, a hagyományos RAID újraépítés akadálya megszűnt, az újraépítési teljesítmény pedig jelentősen megnőtt. Ha új lemezeket adunk hozzá, az ideiglenes területeken lévő adatok átkerülnek az új csatlakoztatott lemezekre.

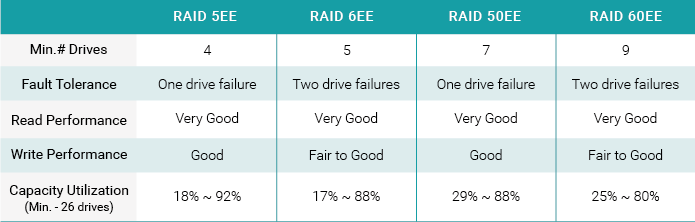

A RAID EE négy új RAID szintet biztosít:

- RAID 5EE (az E jelentése Enhanced azaz felgyorsított), legalább 4 merevlemez meghajtót igényel egy RAID EE tartaléklemezzel, mely eltűri 2 meghajtó hibáját. Több RAID EE hozzáadása nyilvánvalóan több lemez hibáját fogja eltűrni.

- RAID 6EE minimum 5 lemezmeghajtót igényel.

- RAID 50EE minimum 7 lemezmeghajtót igényel.

- RAID 60EE minimum 9 lemezmeghajtót igényel.

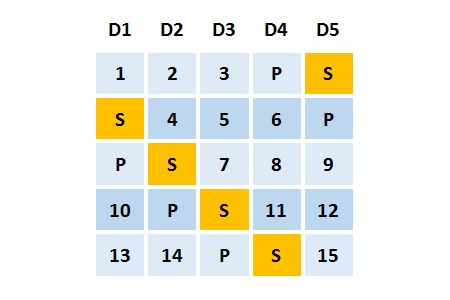

Példa RAID 5EE – 1 RAID EE-kiegészítővel

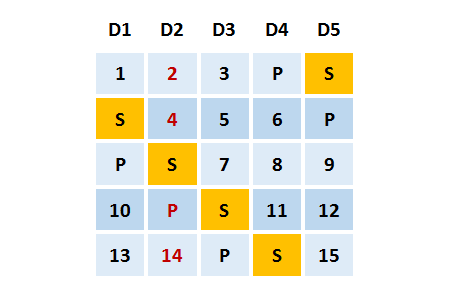

És most vegyünk egy példát ez hogyan is működik. A következő példában a RAID 5EE-t nézzük 5 lemezzel. 4 lemez a RAID diskek számára, és egy további a RAID EE számára. Az inicializálás után, az adatblokkok eloszlása a következő. A P jelentése paritás, az S a RAID EE, és ez most üres.

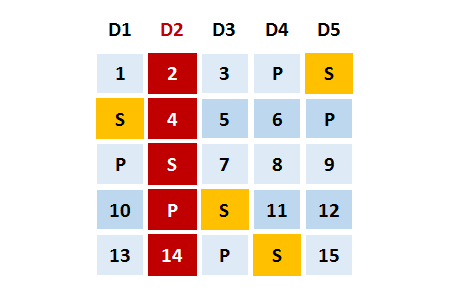

Tegyük fel, hogy a 2-es lemez hibás. A RAID 5EE lefokozó módban van.

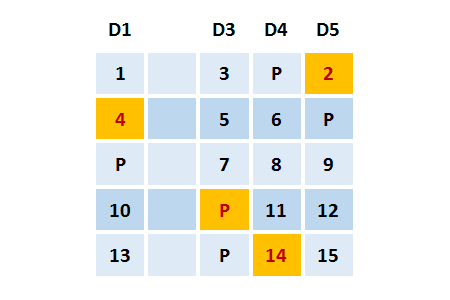

Az ideiglenes területek a hibás lemezek adataival újraépülnek. Ezt a folyamatot hívjuk EE újraépítésnek. Az újraépítés után, a megosztott adatok olyanok, mint a RAID 5-ben és képesek tolerálni egy másik meghajtó hibáját. Ahogy el tudjuk képzelni, minél több RAID EE lemezünk van, annál gyorsabban újraépül.

Ha egy új lemez csatlakozik a RAID EE lemezcsoporthoz, az ideiglenes területen felépített adatok átmásolódnak az új lemezre. Ezt a folyamatot nevezzük Visszamásolásnak. Miután visszamásolódott, a RAID 5EE visszaáll normál állapotba.

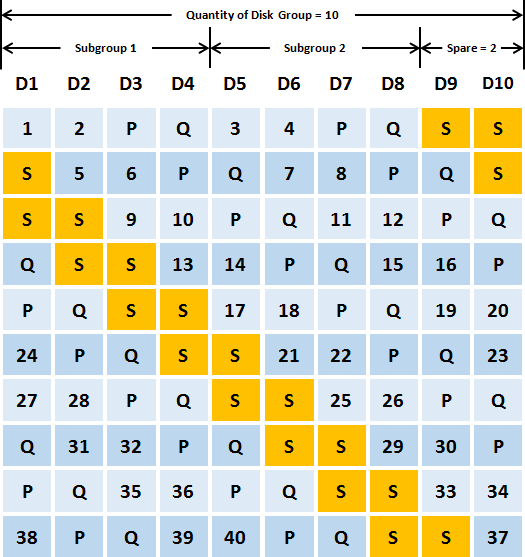

Példa RAID 60EE 2 RAID EE-kiegészítővel

Vegyünk egy másik példát a RAID 60EE-re 10 lemezzel. 8 lemez a RAID disk-ek számára, és 2 a RAID EE számára. Az inicializálás után, az adatblokkok a következőképpen oszlanak szét. A RAID 60EE újraépítése és másolása a fentiekhez hasonló; ezt nem ismételjük meg még egyszer.

Teszteredmények

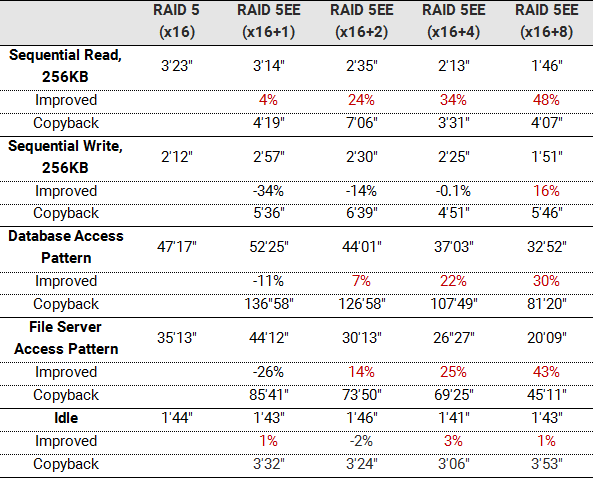

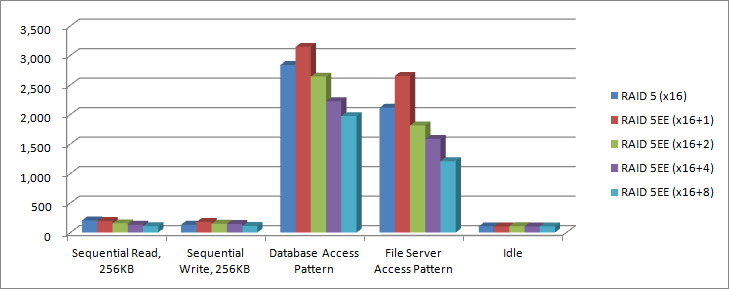

Első teszt: RAID 5 vs. RAID 5EE

Ebben a tesztben összehasonlítjuk az újraépítési és visszamásolási időt a RAID 5 és RAID 5EE között. Feltételezzük, hogy a több RAID EE lemez rövidebb újraépítési időt eredményez. Először is létrehozunk egy RAID 5 pool-t. Az inicializálás után, kihúzzuk és bedugunk egy másik lemez-t. Kiszámítja az újraépítési időt különböző I/O hozzáférési mintákkal. Majd hozzunk létre RAID 5EE-t 1 / 2 / 4 /8 x RAID EE lemezekkel egymás után. Az inicializálás után, húzzunk ki egy lemezt. A RAID EE elkezdi az újraépítést. Kiszámítja az újraépítési időt különböző I/O hozzáférési mintákkal. Ezután helyezzen be egy lemezt és állítsa be dedikált tartalékként, majd elkezdi a visszamásolást. Végezetül, kiszámítja a visszamásolási időt.

Összefoglalás

- A RAID EE képes felgyorsítani az újraépítést akár 48%-kal.

- A több RAID EE lemez használata rövidebb újraépítési időt eredményez.

- Az újraépítési idő hatékonyabb, ha olvasási hozzáférés is van.

|

Szerver

I/O

|

Tároló

|

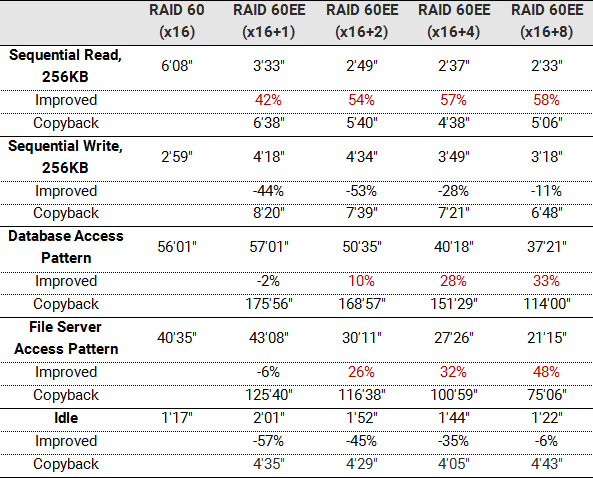

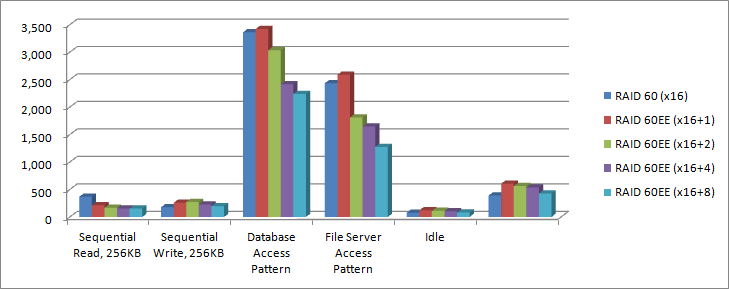

Második teszt: RAID 60 vs. RAID 60EE

Ez a teszt a RAID 60 és a RAID 60EE közötti újraépítési idő és a visszamásolási idő összehasonlítását biztosítja. Feltételezzük, hogy a több RAID EE tartaléklemez kevesebb újraépítési időt és a RAID 60EE nagyobb hatékonyságát fogja biztosítani. Először is létrehozunk egy RAID 60 pool-t. Az inicializálás után, húzzon ki, majd csatlakoztasson újra egy lemezmeghajtót. Kiszámítja az újraépítési időt különböző I/O hozzáférési mintákkal. Folytassuk a RAID 60EE létrehozását 1 / 2 / 4 /8 x RAID EE tartaléklemezzel. Az inicilizálás után, húzzon ki egy lemezmeghajtót. A RAID EE elkezd újraépülni. Kiszámítja az újraépítési időt különböző I/O hozzáférési mintákkal. Eztuán csatlakoztasson egy lemezmeghajtót és állítsa be dedikált tartalékként, ezután elkezd visszamásolni. Végezetül, kiszámítja a visszamásolási időt.

Összefoglalás

- A RAID EE képes csökkenteni az újraépítési időt akár 58%-kal.

- A több RAID EE tartaléklemez használata rövidebb újraépítési időt eredményez.

- Az újraépítési idő még hatékonyabb, ha van olvasási hozzáférés.

Teszteszközök és konfigurációk

|

Szerver

|

Storage

|

Konklúzió

Ahogy a lemezkapacitás nő, a RAID újraépítési idő lineárisan növekszik. Minél több lemezmeghajtó található a lemezcsoportban, annál nagyobb a kumulatív hiba növekedési lehetősége, így a lemezmeghajtó kapacitásának növekvő hatása az újjáépítési sebességre. A RAID EE technológia használata jelentősen csökkenti ezeket a kockázatokat.